Hadoop伪分布式系统搭建

1. Hadoop伪分布式集群介绍

准备linux环境[ip、java、hostname、hosts、iptables、chkconfig、ssh、免密码登录]

依赖环境:jdk1.8

官网下载地址:https://archive.apache.org/dist/hadoop/common/hadoop-2.7.5/

配置:

◆ 修改$HADOOP_HOME/etc/hadoop目录下配置文件core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml

◆ 修改hadoop-env.sh、yarn-env.sh、slaves配置。

启动:第一次启动之前需要先格式化

验证:

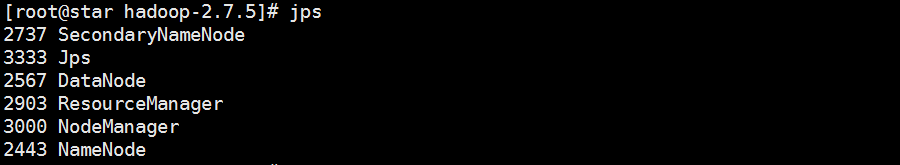

◆ jps验证

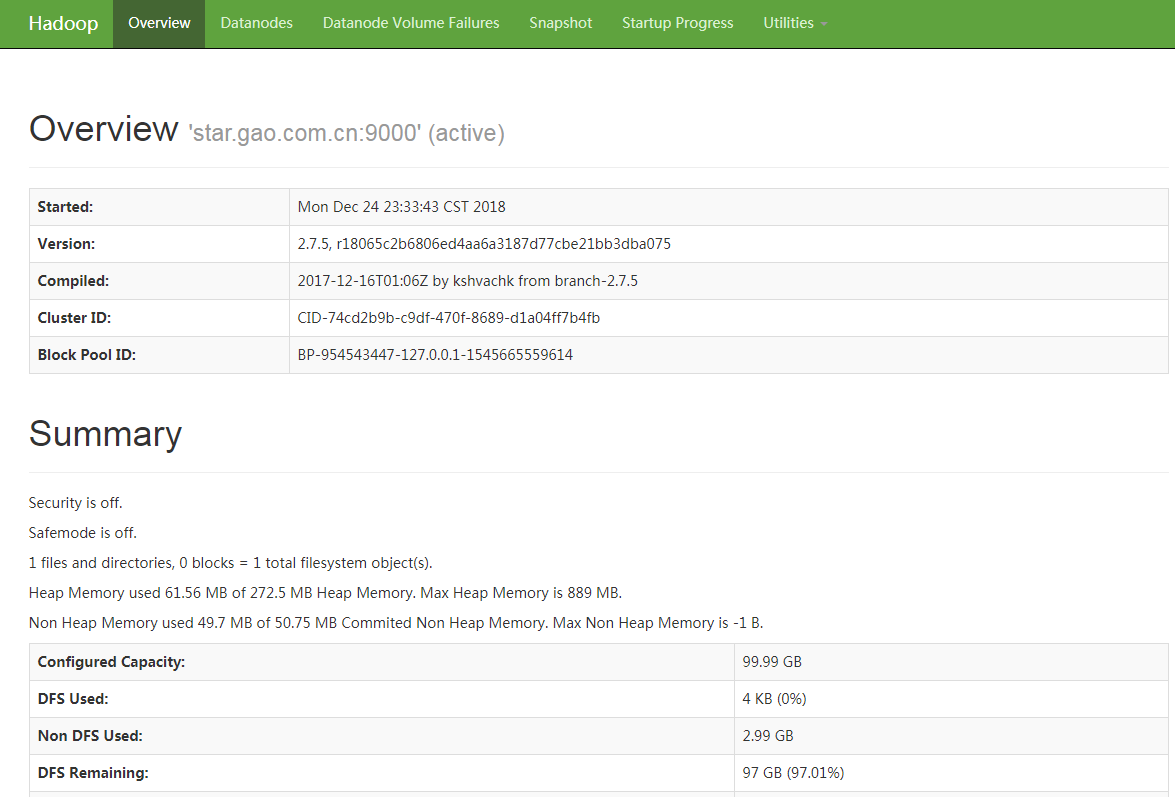

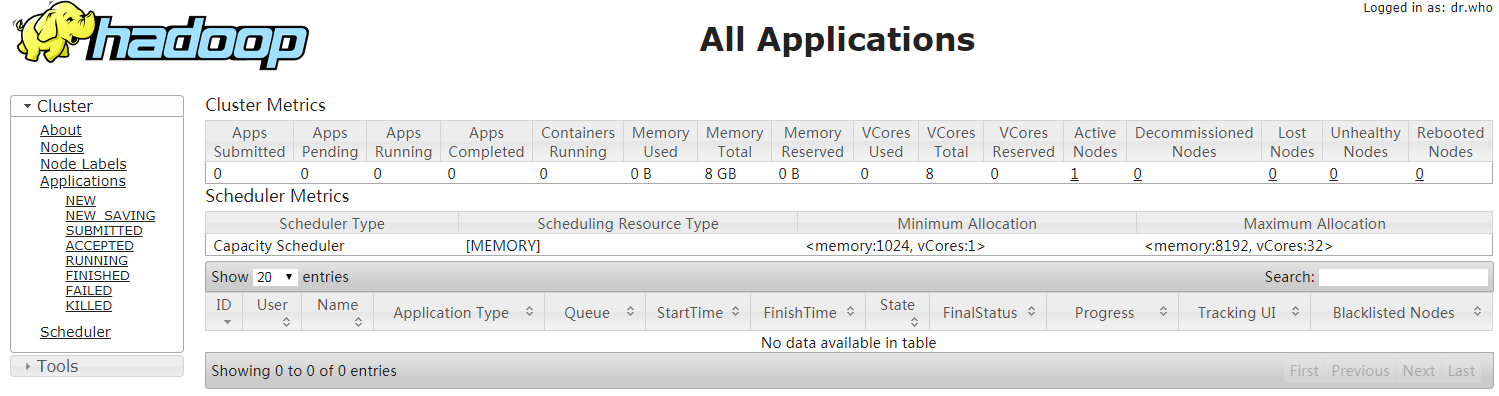

◆ 浏览器验证

◆ hdfs web地址:http://IP:50070

◆ yarn web地址:http://IP:8088

2. 安装JDK和配置环境变量

# 创建soft文件夹 [root@star /]# mkdir /data/soft [root@star /]# cd /data/soft/ [root@star soft]# ls hadoop-2.7.5.tar.gz jdk-8u181-linux-x64.tar.gz # 解压jdk安装包 [root@star soft]# tar -zxvf jdk-8u181-linux-x64.tar.gz # 修改目录名称 [root@star soft]# mv jdk1.8.0_181/ jdk1.8 # 修改环境变量 [root@star /]# vim /etc/profile export JAVA_HOME=/data/soft/jdk1.8 export PATH=.:$JAVA_HOME/bin:$PATH [root@star /]# source /etc/profile # 验证jdk是否安装成功 [root@star /]# java –version java version "1.8.0_181" Java(TM) SE Runtime Environment (build 1.8.0_181-b13) Java HotSpot(TM) 64-Bit Server VM (build 25.181-b13, mixed mode) # 查看JAVA_HOME变量的值 [root@star /]# echo $JAVA_HOME /data/soft/jdk1.8 # 编辑hosts [root@star /]# vim /etc/hosts 10.0.0.181 star.gao.com.cn # 关闭防火墙(6.0) 查看防火墙状态:service iptables status 关闭防火墙:service iptables stop # 把防火墙从开机启动项里面移除掉 查看iptables是否是开机运行的:chkconfig --list | grep iptables 关闭iptables的开机启动项:chkconfig iptables off

3. 配置免密登录

【注意】主节点能够免密登录所有从节点即可。

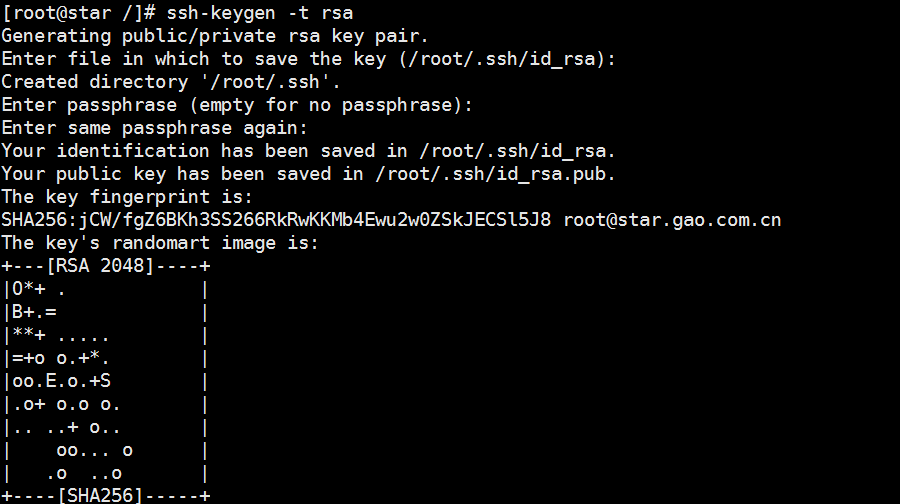

# 在root用户使用ssh工具生成秘钥(也可以使用普通用户) [root@star /]# ssh-keygen -t rsa

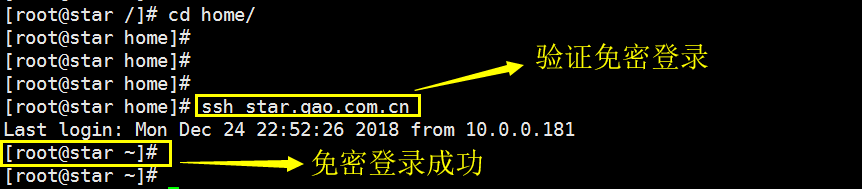

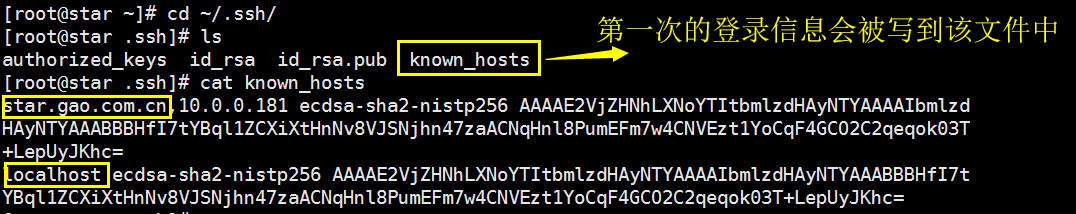

#·本地免密登录 [root@star /]# cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys [root@star ~]# cd ~/.ssh/ [root@star .ssh]# ls authorized_keys id_rsa id_rsa.pub known_hosts

4. 伪分布式安装步骤

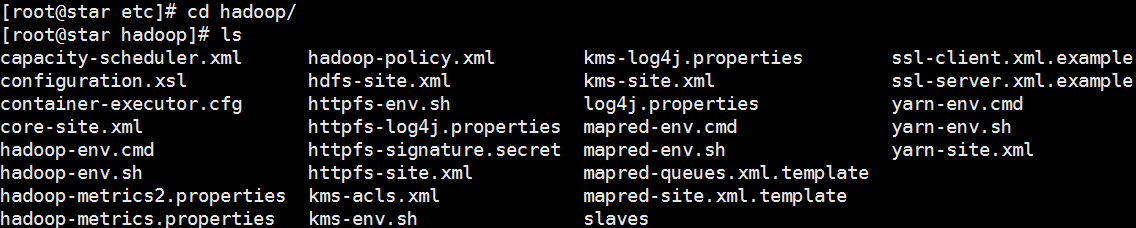

#解压hadoop安装包 [root@star soft]# tar -zxvf hadoop-2.7.5.tar.gz #修改配置文件 [root@star soft]# cd /hadoop-2.7.5/etc/hadoop

[root@star hadoop]# vim hadoop-env.sh # The java implementation to use. export JAVA_HOME=/data/soft/jdk1.8 export HADOOP_LOG_DIR=/data/hadoop_repo/logs/hadoop [root@star hadoop]# vim yarn-env.sh export JAVA_HOME=/data/soft/jdk1.8 export YARN_LOG_DIR=/data/hadoop_repo/logs/yarn [root@star hadoop]# vim core-site.xml <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://star.gao.com.cn:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/data/hadoop_repo</value> </property> </configuration> [root@star hadoop]# vim hdfs-site.xml <configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration> [root@star hadoop]# vim yarn-site.xml <configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration> [root@star hadoop]#mv mapred-site.xml.template mapred-site.xml [root@star hadoop]# vim mapred-site.xml <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> [root@star /]#vim /etc/profile export PATH=.:$JAVA_HOME/bin:$HADOOP_HOME/bin:$PATH #增加红色部分,方便调用hadoop命令,无需切到对应目录 [root@star hadoop]# vim slaves localhost # 对hdfs进行格式化【注意,只能格式化一次】 [root@star hadoop-2.7.5]# bin/hdfs namenode -format # 启动 [root@star hadoop-2.7.5]# sbin/start-all.sh # 验证 [root@star hadoop-2.7.5]# jps

http://IP:50070 #star.gao.com.cn

http://IP:8088 # star.gao.com.cn

# 停止 [root@star hadoop-2.7.5]# sbin/stop-all.sh

作者:UStarGao

链接:https://www.starcto.com/Cloud-BigData-AI/116.html

来源:STARCTO

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

UCloud云平台推荐

随便看看

- 2021-09-17MySQL优化器之Cardinality(Analyze table)

- 2022-01-15K8S Pod模板介绍

- 2021-05-29MongoDB全量备份+oplog增量备份数据恢复方案

- 2021-12-09Windows云主机虚拟内存配置导致系统盘暴增

- 2023-03-12Linux pstree命令树状图方式查看进程